Page 89 - 70

P. 89

Теорія інформації є подальшим розвитком теорії ймовірностей сто-

совно процесів вимірювання. К.Шеннон писав: “Основна ідея теорії

інформації полягає в тому, що з інформацією можна поводитися

майже так само, як із такими фізичними величинами, як маса і енер-

гія”. Але “майже” не означає “точно так само”. Н.Вінер стверджує:

“Інформація є інформація, а не речовина і не енергія”.

На основі історичного досвіду визначення інтервалу невизначеності

результатів вимірювань слідує, що цей інтервал немає од-

нозначного співвідношення з оцінкою СКВ , тобто оцінка потуж-

ності завади не визначає однозначно її дезінформуючий вплив. Для

корекції цієї невизначеності необхідно при різних законах розподі-

лу приймати різні значення довірчої ймовірності, стараючись тим

самим врахувати ще деяку властивість похибки крім її потужності,

яка характеризується за допомогою СКВ .

Так при рівномірному законі розподілу похибки інтервал невизна-

ченості приймають рівним всій ширині цього розподілу, тобто при-

ймають, що довірча ймовірність Р 1. При нормальному законі

розподілу як правило переходять до довірчої ймовірності Р 0, 95.

Аналізуючи дезінформаційний вплив випадкових завад з різними

законами розподілу ймовірностей К.Шеннон прийшов до вис-новку,

що дезінформація, яка вноситься завадою, визначається не тільки

потужністю цієї завади, тобто її СКВ , але і залежить від виду за-

кона розподілу цієї завади.

Формально це положення К.Шеннон сформулював у своїй 16-

ій теоремі, яка стверджує, що якщо завада у вірогідному розумінні

не залежить від сигналу, то незалежно від закону розподілу і потуж-

ності сигналу дезінформаційна дія завади визначається її ентропією

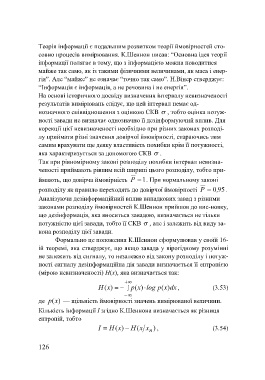

(мірою невизначеності) Н(х), яка визначається так:

H( x) p( x) log p( x) dx , (3.53)

де (xp ) — щільність ймовірності значень вимірюваної величини.

Кількість інформації І згідно К.Шеннона визначається як різниця

ентропій, тобто

I H (x ) H ( xx n ) , (3.54)

126