Page 250 - 4195

P. 250

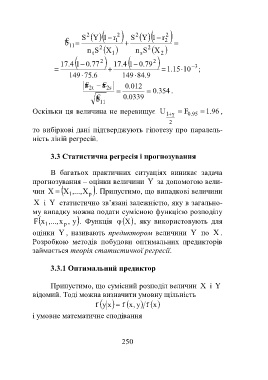

S 2 1Y r 2 S 2 1Y r 2

€

b 1 2

11

n t S 2 X 1 n s S 2 X 2

2 2

17 4 . 1 . 0 77 17 4 . 1 . 0 79

. 1 15 10 3 ;

149 75 6 . 149 84 9 .

a € a € s 2 . 0 012

t 2

. 0 354 .

€

b 11 . 0 0339

Оскільки ця величина не перевищує U 1 F . 0 95 . 1 96 ,

2

то вибіркові дані підтверджують гіпотезу про паралель-

ність ліній регресій.

3.3 Статистична регресія і прогнозування

В багатьох практичних ситуаціях виникає задача

прогнозування – оцінки величини Y за допомогою вели-

чин X X 1 ,..., X p . Припустимо, що випадкові величини

X і Y статистично зв’язані залежністю, яку в загально-

му випадку можна подати сумісною функцією розподілу

F ,...,x 1 x p , y . Функція X , яку використовують для

оцінки Y , називають предиктором величини Y по X .

Розробкою методів побудови оптимальних предикторів

займається теорія статистичної регресії.

3.3.1 Оптимальний предиктор

Припустимо, що сумісний розподіл величин X і Y

відомий. Тоді можна визначити умовну щільність

f xy f y,x xf

і умовне математичне сподівання

250