Page 111 - 4724

P. 111

тобто фактори повинні бути незалежними один від одного. Не

повинно бути точного лінійного зв’язку між двома або більше

факторами. Мультиколінеарність не має значення для простої

лінійної регресії, але надзвичайно важливе для

багатофакторної регресії. Мультиколінеарність не є

проблемою, якщо єдиною метою регресійного аналізу є

прогноз (оскільки чим більше значення R2, тим точніший

прогноз). Якщо метою аналізу є не прогноз, а дійсне значення

параметрів, то мультиколінеарність перетворюється на

проблему, оскільки її наявність призводить до значних

стандартних похибок оцінок параметрів.

Наявність мультіколінеарності перевіряють за допомогою

коефіцієнтів кореляції. Чим ближче коефіцієнт коло одиниці,

тим сильніший взаємозв’язок між факторами. При наявності

мультиколінеарності один фактор необхідно виключити.

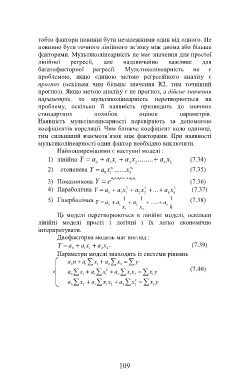

Найпоширенішими є наступні моделі :

1) лінійна Y a a x a x ........ a x (7.34)

0 1 1 2 2 k k

k a

2) степенева Y a x ....... x (7.35)

a 1

0 1 k

a a 1 x... k a k x

3) Показникова Y e 0 (7.36)

2

2

2

4) Параболічна Y a a x a x ... a x (7.37)

0 1 1 2 2 k k

5) Гіперболічна 1 1 1 (7.38)

Y

a

0 a 1 a 2 ..... a k

x x k

1 2

Ці моделі перетворюються в лінійні моделі, оскільки

лінійні моделі прості і логічні і їх легко економічно

інтерпретувати.

Двофакторна модель має вигляд :

Y a a x a x . (7.39)

0 1 1 2 2

Параметри моделі знаходять із системи рівнянь

a n a x a x y

0 1 1 2 2

a x a x 2 a xx yx (7.40)

0 1 1 1 2 1 2 1

a x a xx a x 2 x y

0 2 1 1 2 2 2 2

109