Page 67 - 4162

P. 67

що приходиться на одне повідомлення, про стан

двопозиційного об’єкту, коли ці повідомлення нерівно

ймовірні. Для крайнього випадку, коли об’єкт завжди

відключений P 1 , 0 P 2 0 , середня кількість інформації,

яку несе на собі сигнал повідомлення, дорівнює

H log1 1 0 log 0 0

2 2

Очевидно, що в такому випадку необхідність у

передачі повідомлень про стан об’єкта взагалі відсутня, тому

що прийом диспетчером сигналу, що підтверджує

відключений стан об’єкта, не змінить його освідомленності в

цьому питанні.

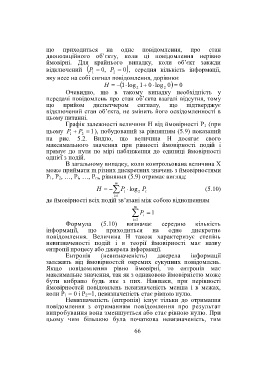

Графік залежності величини H від ймовірності Р 1 (при

цьому P P 1), побудований за рівнянням (5.9) показаний

1 2

на рис. 5.2. Видно, що величина Н досягає свого

максимального значення при рівності ймовірності подій і

прямує до нуля по мірі наближення до одиниці ймовірності

однієї з подій.

В загальному випадку, коли контрольована величина Х

може приймати m різних дискретних значень з ймовірностями

Р 1, Р 2, …, Р і, …, Р m, рівняння (5.9) отримає вигляд:

m

H P i log 2 P (5.10)

i

i 1

де ймовірності всіх подій зв’язані між собою відношенням

m

P i 1

i 1

Формула (5.10) визначає середню кількість

інформації, що приходиться на одне дискретне

повідомлення. Величина Н також характеризує степінь

невизначеності подій і в теорії ймовірності має назву

ентропії процесу або джерела інформації.

Ентропія (невизначеність) джерела інформації

залежить від ймовірностей окремих сукупних повідомлень.

Якщо повідомлення рівно ймовірні, то ентропія має

максимальне значення, так як з однаковою ймовірністю може

бути вибрано будь яке з них. Навпаки, при нерівності

ймовірностей повідомлень невизначеність менша і в межах,

коли Р 1 = 0 і Р 2=1, невизначеність стає рівною нулю.

Невизначеність (ентропія) існує тільки до отримання

повідомлення з отриманням повідомлення про результат

випробування вона зменшується або стає рівною нулю. При

цьому чим більшою була початкова невизначеність, тим

66