Page 31 - 4143

P. 31

розповсюдження, обумовлено тим, що настроюванні значення

синапсів фактично не обмежені.

На другому кроці циклу поперемінно пред'являються всі образи з

вхідного набору.

Слід зазначити, що вид відгуків на кожний клас вхідних образів не

відомий наперед і буде довільним поєднанням станів нейронів

вихідного шару, обумовленим випадковим розподілом вагових

коефіцієнтів на стадії ініціалізації. Разом з тим, мережа здатна

узагальнювати схожі образи, відносячи їх до одного класу.

Тестування навченої мережі дозволяє визначити топологію класів у

вихідному шарі. Для приведення відгуків навченої мережі до

зручного уявлення мережа може бути доповнена ще одним шаром,

який в процесі навчання за алгоритмом одношарового перцептрона

[32] дозволяє відображати вихідні реакції мережі в необхідному

вигляді.

Інший алгоритм навчання без вчителя - алгоритм Кохонена -

передбачає настроювання синапсів на підставі їх значень після

попередньої ітерації.

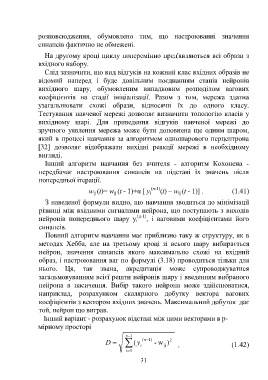

w (t)= w (t - 1)+α [ y i (n-1) (t) – w (t - 1)] . (1.41)

ij

ij

ij

З наведеної формули видно, що навчання зводиться до мінімізації

різниці між вхідними сигналами нейрона, що поступають з виходів

(n-1)

нейронів попереднього шару y i , і ваговими коефіцієнтами його

синапсів.

Повний алгоритм навчання має приблизно таку ж структуру, як в

методах Хебба, але на третьому кроці зі всього шару вибирається

нейрон, значення синапсів якого максимально схожі на вхідний

образ, і настроювання ваг по формулі (3.18) проводиться тільки для

нього. Ця, так звана, акредитація може супроводжуватися

загальмовуванням всієї решти нейронів шару і введенням вибраного

нейрона в насичення. Вибір такого нейрона може здійснюватися,

наприклад, розрахунком скалярного добутку вектора вагових

коефіцієнтів з вектором вхідних значень. Максимальний добуток дає

той, нейрон що виграв.

Інший варіант - розрахунок відстані між цими векторами в р-

мірному просторі

p 1 (n )1

D (y i - w ij 2 ) , (1.42)

i 0

31