Page 26 - 4143

P. 26

гладкі функції, як гіперболічний тангенс або класичний сигмоід з

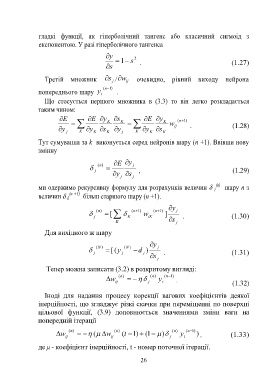

експонентою. У разі гіперболічного тангенса

y 2

1 s . (1.27)

s

Третій множник s j / w ij очевидно, рівний виходу нейрона

( n ) 1

попереднього шару y i .

Що стосується першого множника в (3.3) то він легко розкладається

таким чином:

E E y K s K E y K ( n ) 1

w ij . (1.28)

y y s y y s

j K K K j K K K

Тут сумування за k виконується серед нейронів шару (n +1). Ввівши нову

змінну

E y

( n) j

j , (1.29)

y s

j j

(n)

ми одержимо рекурсивну формулу для розрахунків величин шару n з

j

величин k (n +1) більш старшого шару (n +1).

y

( n) ( n )1 ( n )1 j

[ w ]

j K iK . (1.30)

K s j

Для вихідного ж шару

y

( N ) ( N ) j

j y ( [ j d ) . (1.31)

j

s

j

Тепер можна записати (3.2) в розкритому вигляді:

w (n ) (n ) y ( n ) 1

ij j i . (1.32)

Іноді для надання процесу корекції вагових коефіцієнтів деякої

інерційності, що згладжує різкі скачки при переміщенні по поверхні

цільової функції, (3.9) доповнюється значеннями зміни ваги на

попередній ітерації

(n ) (n ) (n ) (n ) 1

w ( w ( t ) 1 1 ( ) y ) , (1.33)

ij ij j i

де μ - коефіцієнт інерційності, t - номер поточної ітерації.

26