Page 27 - 4143

P. 27

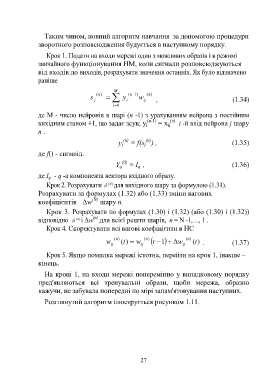

Таким чином, повний алгоритм навчання за допомогою процедури

зворотного розповсюдження будується в наступному порядку.

Крок 1. Подати на входи мережі один з можливих образів і в режимі

звичайного функціонування НМ, коли сигнали розповсюджуються

від входів до виходів, розрахувати значення останніх. Як було відзначено

раніше

M

( n) n ( )1 ( n)

s j y i w ij , (1.34)

i 0

де М - число нейронів в шарі (n -1) з урахуванням нейрона з постійним

вихідним станом +1, що задає зсув; y i (n-1) = x ij (n) i -й вхід нейрона j шару

п .

(n)

(n)

y = f(s ) , (1.35)

j

j

де f() - сигмоід.

(0)

Y q = I , (1.36)

q

де I - q -а компонента вектора вхідного образу.

q

Крок 2. Розрахувати (N ) для вихідного шару за формулою (1.31).

Розрахувати за формулах (1.32) або (1.33) зміни вагових

(N)

коефіцієнтів Δw шару n.

Крок 3. Розрахувати по формулах (1.30) і (1.32) (або (1.30) і (1.32))

(n)

відповідно і Δw для всієї решти шарів, n = N -1, ..., 1 .

(

) n

Крок 4. Скоректувати всі вагові коефіцієнти в НС

(n ) (n ) (n )

w ij (t ) w ij t 1 w ij (t ) . (1.37)

Крок 5. Якщо помилка мережі істотна, перейти на крок 1, інакше –

кінець.

На кроці 1, на входи мережі поперемінно у випадковому порядку

пред'являються всі тренувальні образи, щоби мережа, образно

кажучи, не забувала попередні по мірі запам'ятовування наступних.

Розглянутий алгоритм ілюструється рисунком 1.11.

27