Page 32 - 4143

P. 32

де р - розмірність векторів, j - індекс нейрона в шарі п, i - індекси

підсумовування по нейронах (n -1) -го шару, w - вага синапсу, що

ij

з’єднує нейрони; виходи нейронів (п -1) -го шару є вхідними

значеннями для шару п. Корінь у формулі (1.42) брати не

обов'язково, оскільки важлива лише відносна оцінка різних D .

j

У даному випадку, "перемагає" нейрон з якнайменшою

відстанню. Іноді дуже часто одержуючи акредитацію нейрони

примусово виключаються з розгляду, щоб "зрівняти права" всіх

нейронів шару. Найпростіший варіант такого алгоритму полягає в

гальмуванні нейрона, який тільки що виграв.

При практичному використовуванні для навчання алгоритму

Кохонена, як правило, здійснюється нормалізація вхідних образів.

При цьому на стадії ініціалізації здійснюється нормалізація

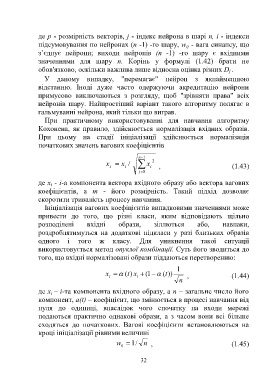

початкових значень вагових коефіцієнтів

n 1 2

x i x i / x i , (1.43)

j 0

де x - i-а компонента вектора вхідного образу або вектора вагових

i

коефіцієнтів, а т - його розмірність. Такий підхід дозволяє

скоротити тривалість процесу навчання.

Ініціалізація вагових коефіцієнтів випадковими значеннями може

привести до того, що різні класи, яким відповідають щільно

розподілені вхідні образи, зіллються або, навпаки,

роздроблятимуться на додаткові підкласи у разі близьких образів

одного і того ж класу. Для уникнення такої ситуації

використовується метод опуклої комбінації. Суть його зводиться до

того, що вхідні нормалізовані образи піддаються перетворенню:

1

x ( t) x 1 ( ( t)) , (1.44)

i

i

n

де x – і-та компонента вхідного образу, а п – загальне число його

i

компонент, а(t) – коефіцієнт, що змінюється в процесі навчання від

нуля до одиниці, внаслідок чого спочатку на входи мережі

подаються практично однакові образи, а з часом вони всі більше

сходяться до початкових. Вагові коефіцієнти встановлюються на

кроці ініціалізації рівними величині

w / 1 n , (1.45)

0

32