Page 30 - 4143

P. 30

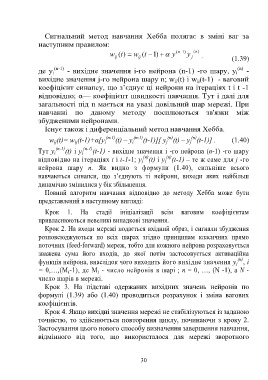

Сигнальний метод навчання Хебба полягає в зміні ваг за

наступним правилом:

w (t ) w (t ) 1 y (n ) 1 y (n )

ij ij j ,

(1.39)

(n)

де y i (n-1) - вихідне значення i-го нейрона (n-1) -го шару, y -

i

вихідне значення j-го нейрона шару n; w (t) і w (t-1) - ваговий

ij

ij

коефіцієнт синапсу, що з’єднує ці нейрони на ітераціях t і t -1

відповідно; α— коефіцієнт швидкості навчання. Тут і далі для

загальності під n мається на увазі довільний шар мережі. При

навчанні по даному методу посилюються зв'язки між

збудженими нейронами.

Існує також і диференціальний метод навчання Хебба.

(n)

(n)

w (t)= w (t-1)+α[y i (n-1) (t) – y i (n-1) (t-1)][ y (t) – y (t-1)] . (1.40)

ij

ij

j

j

(n-1) (n-1)

Тут y i (t) і y i (t-1) - вихідне значення i -го нейрона (n-1) -го шару

(n)

(n)

відповідно на ітераціях t і t-1-1; y (t) і y (t-1) – те ж саме для j -го

j

j

нейрона шару п. Як видно з формули (1.40), сильніше всього

навчаються синапси, що з’єднують ті нейрони, виходи яких найбільш

динамічно змінилися у бік збільшення.

Повний алгоритм навчання відповідно до методу Хебба може бути

представлений в наступному вигляді:

Крок 1. На стадії ініціалізації всім ваговим коефіцієнтам

привласнюються невеликі випадкові значення.

Крок 2. На входи мережі подається вхідний образ, і сигнали збудження

розповсюджуються по всіх шарах згідно принципам класичних прямо

поточних (feed-forward) мереж, тобто для кожного нейрона розраховується

зважена сума його входів, до якої потім застосовується активаційна

(n)

функція нейрона, внаслідок чого виходить його вихідне значення y , i

j

= 0,…,(M -1), де M - число нейронів в шарі ; п = 0, …, (N -1), а N -

i

i

число шарів в мережі.

Крок 3. На підставі одержаних вихідних значень нейронів по

формулі (1.39) або (1.40) проводиться розрахунок і зміна вагових

коефіцієнтів.

Крок 4. Якщо вихідні значення мережі не стабілізуються із заданою

точністю, то здійснюється повторення циклу, починаючи з кроку 2.

Застосування цього нового способу визначення завершення навчання,

відмінного від того, що використалося для мережі зворотного

30