Page 25 - 4143

P. 25

всієї мережі. Очевидно, що даний метод "проб", не дивлячись на

свою уявну простоту, вимагає громіздких рутинних обчислень. І,

нарешті, третій, більш прийнятний варіант - розповсюдження

сигналів помилки від виходів до її входів, в напрямі, що э

зворотним до прямого розповсюдження сигналів в звичному

режимі роботи. Цей алгоритм навчання одержав назву процедури

зворотного розповсюдження (back-propagation algorithm) і є таким,

що найбільш широко використовується. Саме він буде більш

докладно розглянутий надалі.

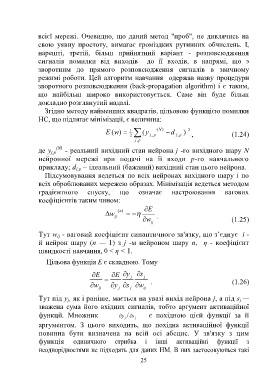

Згідно методу найменших квадратів, цільовою функцією помилки

НС, що підлягає мінімізації, є величина:

1

E (w ) 2 (y j , p (N ) d j , p ) 2 , (1.24)

j , p

де y j,p (N) - реальний вихідний стан нейрона j -го вихідного шару N

нейронної мережі при подачі на її входи р-го навчального

прикладу; d – ідеальний (бажаний) вихідний стан цього нейрона.

j,p

Підсумовування ведеться по всіх нейронах вихідного шару і по

всіх оброблюваних мережею образах. Мінімізація ведеться методом

градієнтного спуску, що означає настроювання вагових

коефіцієнтів таким чином:

E

( n)

w

ij .

w (1.25)

ij

Тут w - ваговий коефіцієнт синаптичного зв'язку, що з’єднує i -

ij

й нейрон шару (п — 1) з j -м нейроном шару п, η - коефіцієнт

швидкості навчання, 0 < η < 1.

Цільова функція Е є складною. Тому

E E y j s j

. (1.26)

w y s w

ij j j ij

Тут під y , як і раніше, мається на увазі вихід нейрона j, а під s —

j

j

зважена сума його вхідних сигналів, тобто аргумент активаційної

функції. Множник / s є похідною цієй функції за її

y

j

j

аргументом. З цього виходить, що похідна активаційної функції

повинна бути визначена на всій осі абсцис. У зв'язку з цим

функція одиничного стрибка і інші активаційні функції з

неоднорідностями не підходять для даних НМ. В них застосовуються такі

25