Page 15 - 4143

P. 15

(Σ)

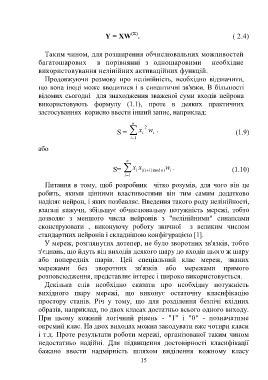

Y = XW . ( 2.4)

Таким чином, для розширення обчислювальних можливостей

багатошарових в порівнянні з одношаровими необхідне

використовування нелінійних активаційних функцій.

Продовжуючи розмову про нелінійність, необхідно відзначити,

що вона іноді може вводитися і в синаптичні зв'язки. В більшості

відомих сьогодні для знаходження зваженої суми входів нейрона

використовують формулу (1.1), проте в деяких практичних

застосуваннях корисно ввести інший запис, наприклад:

n 2

.

S = x i w i (1.9)

i 1

або

n

S= x i x ((i ) 1 mod ) n w i . (1.10)

i 1

Питання в тому, щоб розробник чітко розумів, для чого він це

робить, якими цінними властивостями він тим самим додатково

наділяє нейрон, і яких позбавляє. Введення такого роду нелінійності,

взагалі кажучи, збільшує обчислювальну потужність мережі, тобто

дозволяє з меншого числа нейронів з "нелінійними" синапсами

сконструювати , виконуючу роботу звичної з великим числом

стандартних нейронів і складнішою конфігурацією [1].

У мереж, розглянутих дотепер, не було зворотних зв'язків, тобто

з'єднань, що йдуть від виходів деякого шару до входів цього ж шару

або попередніх шарів. Цей спеціальний клас мереж, званих

мережами без зворотних зв'язків або мережами прямого

розповсюдження, представляє інтерес і широко використовується.

Декілька слів необхідно сказати про необхідну потужність

вихідного шару мережі, що виконує остаточну класифікацію

простору станів. Річ у тому, що для розділення безлічі вхідних

образів, наприклад, по двох класах достатньо всього одного виходу.

При цьому кожний логічний рівень - "1" і "0" - позначатиме

окремий клас. На двох виходах можна закодувати вже чотири класи

і т.д. Проте результати роботи мережі, організованої таким чином

недостатньо надійні. Для підвищення достовірності класифікації

бажано ввести надмірність шляхом виділення кожному класу

15