Page 20 - 4143

P. 20

k

x i

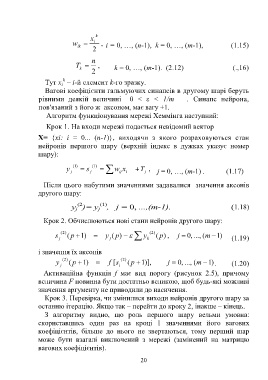

w , i = 0, …, (n-1), k = 0, …, (m-1), (1.15)

ik

2

n

T , k = 0, …, (m-1). (2.12) (.,16)

k

2

k

Тут x – i-й елемент k-го зразку.

i

Вагові коефіцієнти гальмуючих синапсів в другому шарі беруть

рівними деякій величині 0 < ε < 1/m . Синапс нейрона,

пов'язаний з його ж аксоном, має вагу +1.

Алгоритм функціонування мережі Хеммінга наступний:

Крок 1. На входи мережі подається невідомий вектор

Х= {xi: i = 0... (n-1)}, виходячи з якого розраховуються стан

нейронів першого шару (верхній індекс в дужках указує номер

шару):

) 1 ( ) 1 (

,

y j s j w ij x i T j j = 0, …, (m-1) . (1.17)

Після цього набутими значеннями задавалися значення аксонів

другого шару:

(2 (1)

y )= y j , j = 0, ...,(m-1). (1.18)

j

Крок 2. Обчислюються нові стани нейронів другого шару:

s j ) 2 ( ( p ) 1 y j ( p ) y k ) 2 ( ( , ) p j , 0 ..., ( m ) 1 (1.19)

і значення їх аксонів

) 2 ( ) 2 (

y j ( p ) 1 f [s i ( p 1 )], j , 0 ..., ( m ) 1 . (1.20)

Активаційна функція f має вид порогу (рисунок 2.5), причому

величина F повинна бути достатньо великою, щоб будь-які можливі

значення аргументу не приводили до насичення.

Крок 3. Перевірка, чи змінилися виходи нейронів другого шару за

останню ітерацію. Якщо так – перейти до кроку 2, інакше – кінець.

З алгоритму видно, що роль першого шару вельми умовна:

скориставшись один раз на кроці 1 значеннями його вагових

коефіцієнтів, більше до нього не звертаються, тому перший шар

може бути взагалі виключений з мережі (замінений на матрицю

вагових коефіцієнтів).

20