Page 25 - 4522

P. 25

1

H log log P , (3.3)

2 2

P

(3.3) – формула американського вченого Хартлі (1928 р.)

Кількість інформації, що припадає на одне

повідомлення, дорівнює двійковому логарифму числа

можливих станів об’єкту.

При кодуванні дискретних сигналів за системою

n

двійкового комплектного коду m 2 , тому

H log 2 n n , (3.4)

2

тобто кількість інформації, що відповідає передачі одного

повідомлення, дорівнює числу елементів в кодованому

сигналі.

Загалом, коли повідомлення, що утворюють ансамбль,

нерівно ймовірні, кількість інформації, яку несе на собі той чи

інший сигнал повідомлення, залежить від ймовірності.

Повернемося до двохпозиційного об’єкту.

Позначимо:

Р 1 – ймовірність появи повідомлення «відключено»;

Р 2 – ймовірність появи повідомлення «включено».

Сигнали, що відповідають цим повідомленням, як і

раніше, позначимо цифрами 1 і 0. Будемо вести

спостереження за сигналами і через строго визначені

проміжки часу робити помітки про стан об’єкту. В результаті

достатньо тривалого спостереження може бути складено Q

послідовностей, які відрізняються одна від одної порядком

чергування цифр:

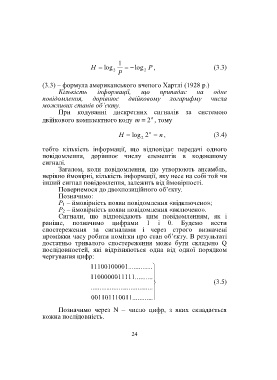

1110010000 1 .......... ....

1100000011 111 ..........

(3.5)

.......... .......... .......... ......

0011011100 11 .......... ..

Позначимо через N – число цифр, з яких складається

кожна послідовність.

24