Page 139 - 4512

P. 139

m

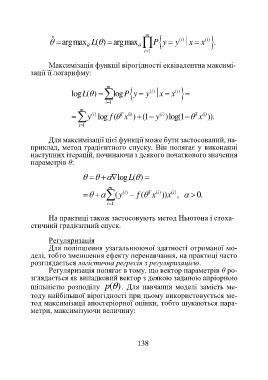

ˆ argmax ( ) argmaxL P y y ( )i x x ( )i .

i 1

Максимізація функції вірогідності еквівалентна максимі-

зації її логарифму:

m

log ( )L logP y y x x ( )i

( )i

i 1

m

y ( )i log (f T x (i) ) (1 y ( )i )log(1 T x (i) )).

i 1

Для максимізації цієї функції може бути застосований, на-

приклад, метод градієнтного спуску. Він полягає у виконанні

наступних ітерацій, починаючи з деякого початкового значення

параметрів θ:

log ( )L

m

(y ( f T x ( )i ))x ( )i , 0.

( )i

i 1

На практиці також застосовують метод Ньютона і стоха-

стичний градієнтний спуск.

Регуляризація

Для поліпшення узагальнюючої здатності отриманої мо-

делі, тобто зменшення ефекту перенавчання, на практиці часто

розглядається логістична регресія з регуляризацією.

Регуляризація полягає в тому, що вектор параметрів θ ро-

зглядається як випадковий вектор з деякою заданою апріорною

щільністю розподілу ( )p . Для навчання моделі замість ме-

тоду найбільшої вірогідності при цьому використовується ме-

тод максимізації апостеріорної оцінки, тобто шукаються пара-

метри, максимізуючи величину:

138