Page 140 - 4512

P. 140

m

P y ( )i x ( )i , p ( ).

i 1

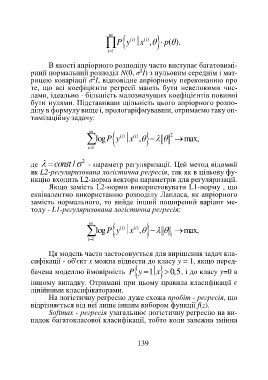

В якості апріорного розподілу часто виступає багатовимі-

2

рний нормальний розподіл N(0, σ I) з нульовим середнім і мат-

2

рицею коваріації σ I, відповідне апріорному переконанню про

те, що всі коефіцієнти регресії мають бути невеликими чис-

лами, ідеально - більшість малозначущих коефіцієнтів повинні

бути нулями. Підставивши щільність цього апріорного розпо-

ділу в формулу вище і, прологаріфмувавши, отримаємо таку оп-

тимізаційну задачу:

m

logP y x ( )i , max,

2

( )i

i 1

де const / 2 - параметр регуляризації. Цей метод відомий

як L2-регуляризована логістична регресія, так як в цільову фу-

нкцію входить L2-норма вектора параметрів для регуляризації.

Якщо замість L2-норми використовувати L1-норму , що

еквівалентно використанню розподілу Лапласа, як апріорного

замість нормального, то вийде інший поширений варіант ме-

тоду - L1-регуляризована логістична регресія:

m

logP y x ( )i , max,

( )i

i 1 1

Ця модель часто застосовується для вирішення задач кла-

сифікації - об'єкт x можна віднести до класу y = 1, якщо перед-

бачена моделлю ймовірність P y 1 x 0,5, і до класу y=0 в

іншому випадку. Отримані при цьому правила класифікації є

лінійними класифікаторами.

На логістичну регресію дуже схожа пробіт - регресія, що

відрізняється від неї лише іншим вибором функції f(z).

Softmax - регресія узагальнює логістичну регресію на ви-

падок багатокласової класифікації, тобто коли залежна змінна

139