Page 206 - 4496

P. 206

інформації. У 1948 році К. Шеннон (До. Зкаппоп) обгрунтував

доцільність використовування кількісної міри інформації, що

дозволило йому сформулювати фундаментальну теорему про

знаходження швидкості передачі інформації по каналах

зв'язку, який можна досягти при деякому оптимальному

методі кодування і декодування, забезпечивши при цьому

скільки завгодно малу вірогідність помилки. Кількісна міра

інформації ентропія є мірою ступеня невизначеності

випадкової величини. Хай деяка випадкова величина ξ,

приймає значення x 1, х 2 ..., х п з розподілом ймовірності р 1, р 2,

..., р n

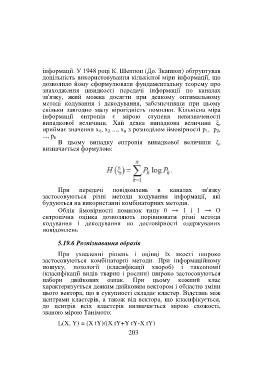

В цьому випадку ентропія випадкової величини ξ,

визначається формулою:

При передачі повідомлень в каналах зв'язку

застосовуються різні методи кодування інформації, які

будуються на використанні комбінаторних методів.

Облік ймовірності помилок типу 0 → 1 і 1 → О

ентропічна оцінка дозволяють порівнювати різні методи

кодування і декодування по достовірності одержуваних

повідомлень

5.19.6 Розпізнавання образів

При ухваленні рішень і оцінці їх якості широко

застосовуються комбінаторні методи. При інформаційному

пошуку, нозології (класифікації хвороб) і таксономії

(класифікації видів тварин і рослин) широко застосовуються

набори двійкових ознак. При цьому кожний клас

характеризується деяким двійковим вектором і областю зміни

цього вектора, що в сукупності складає кластер. Відстань між

центрами кластерів, а також від вектора, що класифікується,

до центрів всіх кластерів визначається мірою схожості,

званою мірою Танімото:

L(X, Y) = (X tY)/(X tY+Y tY-X tY)

203