Page 21 - 128

P. 21

m m m m

*

F p k log 2 p k p k p k log 2 p k p k F ;

k

k 1 k 1 k 1 k 1

F *

k

log p log e 0 log p log e .

p 2 k 2 2 k 2

k

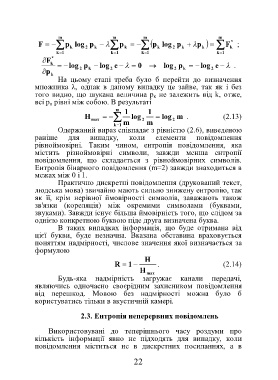

На цьому етапі треба було б перейти до визначення

множника λ, однак в даному випадку це зайве, так як і без

того видно, що шукана величина р к не залежить від k, отже,

всі р к рівні між собою. В результаті

m 1 1

H log log m . (2.13)

max 2 2

k 1 m m

Одержаний вираз співпадає з рівністю (2.6), виведеною

раніше для випадку, коли елементи повідомлення

рівноймовірні. Таким чином, ентропія повідомлення, яка

містить різноймовірні символи, завжди менша ентропії

повідомлення, що складається з рівноймовірних символів.

Ентропія бінарного повідомлення (m=2) завжди знаходиться в

межах між 0 і 1.

Практично дискретні повідомлення (друкований текст,

людська мова) звичайно мають сильно знижену ентропію, так

як її, крім нерівної ймовірності символів, заважають також

зв'язки (кореляція) між окремими символами (буквами,

звуками). Завжди існує більша ймовірність того, що слідом за

однією конкретною буквою піде друга визначена буква.

В таких випадках інформація, що буде отримана від

цієї букви, буде незначна. Вказана обставина враховується

поняттям надмірності, числове значення якої визначається за

формулою

H

R 1 . (2.14)

H

max

Будь-яка надмірність загружає канали передачі,

являючись одночасно своєрідним захисником повідомлення

від перешкод. Мовою без надмірності можна було б

користуватись тільки в акустичній камері.

2.3. Ентропія неперервних повідомлень

Використовувані до теперішнього часу роздуми про

кількість інформації явно не підходять для випадку, коли

повідомлення міститься не в дискретних посиланнях, а в

22