Page 18 - 128

P. 18

1

I log n log m біт . (2.5)

2 n 2

m

Ентропія такого повідомлення вираховується таким чином:

1 біт

H log 2 m . (2.6)

n символ

З формул (2.5) і (2.6) випливає, що при передачі

рівноймовірних повідомлень кількість інформації в

повідомленнях пропорційна переданому числу символів і

логарифму числа можливих символів (букв алфавіту).

Ентропія в цьому випадку залежить тільки від числа

можливих символів (букв алфавіту).

При різній ймовірності можливих повідомлень кількість

інформації, яка передається, визначається з врахуванням

ймовірностей окремих символів алфавіту джерела

повідомлень, приведеного в таблиці 2.2.

Кількість інформації у всьому тексті, що передається

I n log p n log p n log p біт . (2.7)

N 1 2 1 2 2 2 m 2 m

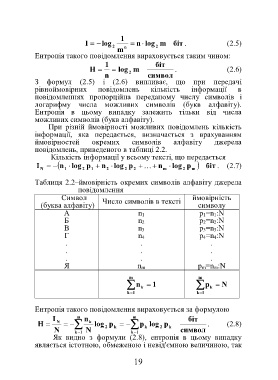

Таблиця 2.2–ймовірність окремих символів алфавіту джерела

повідомлення

Символ Число символів в тексті ймовірність

(буква алфавіту) символу

А n 1 p 1=n 1:N

Б n 2 p 2=n 2:N

В n 3 p 3=n 3:N

Г n 4 p 4=n 4:N

. . .

. . .

. . .

Я n m p m=n m:N

m m

n k 1 p k N

k 1 k 1

Ентропія такого повідомлення вираховується за формулою

I m n m біт

H N k log 2 p k p k log 2 p k . (2.8)

N k 1 N k 1 символ

Як видно з формули (2.8), ентропія в цьому випадку

являється істотною, обмеженою і невід'ємною величиною, так

19