Page 168 - 4196

P. 168

Подання на вхід першого шару деякого вектора

P i,P i 0 ,..., p 1 викликає утворення на вході друго-

го шару іншого вектора Q j,q 0 ,..., m , 1 який зно-

j

ву подається на вхід першого шару. Із збільшенням кіль-

кості ітерацій вектори на виходах обох шарів наближа-

ються до деякої пари зразкових векторів X k , Y , причо-

k

му X подібний до P , а Y - асоційований із ним. Асо-

k

k

ційованість пар векторів задається ваговою матрицею

1 2

W першого шару. Вагова матриця W другого шару

T

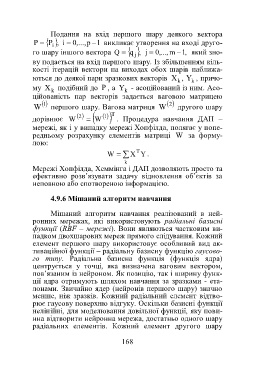

дорівнює W 2 W 1 . Процедура навчання ДАП –

мережі, як і у випадку мережі Хопфілда, полягає у попе-

редньому розрахунку елементів матриці W за форму-

лою:

T

W X Y .

k

Мережі Хопфілда, Хеммінга і ДАП дозволяють просто та

ефективно розв’язувати задачу відновлення об’єктів за

неповною або спотвореною інформацією.

4.9.6 Мішаний алгоритм навчання

Мішаний алгоритм навчання реалізований в ней-

ронних мережах, які використовують радіальні базисні

функції (RBF – мережі). Вони являються частковим ви-

падком двохшарових мереж прямого слідування. Кожний

елемент першого шару використовує особливий вид ак-

тиваційної функції – радіальну базисну функцію гаусово-

го типу. Радіальна базисна функція (функція ядра)

центрується у точці, яка визначена ваговим вектором,

пов’язаним із нейроном. Як позицію, так і ширину функ-

ції ядра отримують шляхом навчання за зразками - ета-

лонами. Звичайно ядер (нейронів першого шару) значно

менше, ніж зразків. Кожний радіальний елемент відтво-

рює гаусову поверхню відгуку. Оскільки базисні функції

нелінійні, для моделювання довільної функції, яку пови-

нна відтворити нейронна мережа, достатньо одного шару

радіальних елементів. Кожний елемент другого шару

168