Page 145 - 4196

P. 145

вектор кожного образу доповнюється компонентою 1 і

T

тоді X ,x 1 x 2 1 , , W W 1 , W 2 , W 3 - поповнені

вектори образів і вагової функції.

Схема навчання, яку прийнято називати алгорит-

мом перцептрону, зводиться до ітераційної процедури,

1

коли на k - кроці навчання ваговий вектор отримає

значення

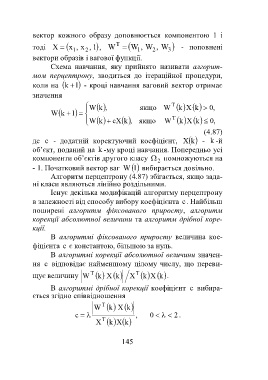

,k якщо W T ,0kXk

W

W 1k

W cXk ,k якщо W T ,0kXk

(4.87)

де c - додатній коректуючий коефіцієнт, kX - k -й

об’єкт, поданий на k -му кроці навчання. Попередньо усі

компоненти об’єктів другого класу помножуються на

2

- 1. Початковий вектор ваг 1W вибирається довільно.

Алгоритм перцептрону (4.87) збігається, якщо зада-

ні класи являються лінійно роздільними.

Існує декілька модифікацій алгоритму перцептрону

в залежності від способу вибору коефіцієнта c. Найбільш

поширені алгоритм фіксованого приросту, алгоритм

корекції абсолютної величини та алгоритм дрібної коре-

кції.

В алгоритмі фіксованого приросту величина кое-

фіцієнта c є константою, більшою за нуль.

В алгоритмі корекції абсолютної величини значен-

ня c відповідає найменшому цілому числу, що переви-

щує величину W T XkXk T kXk .

В алгоритмі дрібної корекції коефіцієнт c вибира-

ється згідно співвідношення

T

W kXk

c , 0 2.

X T kXk

145