Page 76 - 4522

P. 76

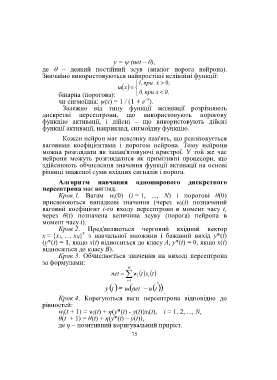

y = ψ (net – θ),

де – деякий постійний зсув (аналог порога нейрона).

Звичайно використовуються найпростіші нелінійні функції:

при 1, x ,0

x

ш

бінарна (порогова): 0, при x 0,

–x

чи сигмоїдна: ψ(x) = 1 / (1 + e ).

Залежно від типу функції активації розрізняють

дискретні персептрони, що використовують порогову

функцію активації, і дійсні – що використовують дійсні

функції активації, наприклад, сигмоїдну функцію.

Кожен нейрон має невелику пам'ять, що реалізовується

ваговими коефіцієнтами і порогом нейрона. Тому нейрони

можна розглядати як запам'ятовуючі пристрої. У той же час

нейрони можуть розглядатися як примітивні процесори, що

здійснюють обчислення значення функції активації на основі

різниці зваженої суми вхідних сигналів і порога.

Алгоритм навчання одношарового дискретного

персептрона має вигляд.

Крок 1. Вагам w i(0) (i = 1, ..., N) і порогові θ(0)

присвоюються випадкові значення (через w i(t) позначений

ваговий коефіцієнт i-го входу персептрона в момент часу t,

через θ(t) позначена величина зсуву (порога) нейрона в

момент часу t).

Крок 2. Пред'являються черговий вхідний вектор

т

х = {х 1, ..., х N} з навчальної множини і бажаний вихід y*(t)

(y*(t) = 1, якщо х(t) відноситься до класу A, y*(t) = 0, якщо х(t)

відноситься до класу В).

Крок 3. Обчислюється значення на виході персептрона

за формулами:

N

net w i txt i

i 1 ,

t

t

y ш net и

.

Крок 4. Корегуються ваги персептрона відповідно до

рівностей:

w i(t + 1) = w i(t) + η(y*(t) - y(t))x i(t), i = 1, 2, ..., N,

θ(t + 1) = θ(t) + η(y*(t) – y(t)),

де η – позитивний коригувальний приріст.

75