Page 152 - 4196

P. 152

J ,W X

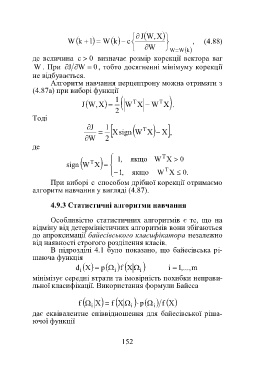

W k 1 W ck , (4.88)

W W W k

0

де величина c визначає розмір корекції вектора ваг

W . При J W 0 , тобто досягненні мінімуму корекції

не відбувається.

Алгоритм навчання перцептрону можна отримати з

(4.87а) при виборі функції

1

J ,W X W T X W T X .

2

Тоді

J 1 T

signX W X X ,

W 2

де

якщо W T X 0

,1

sign W T X

,1 якщо W T X .0

При виборі c способом дрібної корекції отримаємо

алгоритм навчання у вигляді (4.87).

4.9.3 Статистичні алгоритми навчання

Особливістю статистичних алгоритмів є те, що на

відміну від детерміністичних алгоритмів вони збігаються

до апроксимації байесівського класифікатора незалежно

від наявності строгого розділення класів.

В підрозділі 4.1 було показано, що байесівська рі-

шаюча функція

d i pX Xf i i i 1 ,..., m

мінімізує середні втрати та імовірність похибки неправи-

льної класифікації. Використання формули Байеса

p

X

f

f i X f X i

i

дає еквівалентне співвідношення для байесівської ріша-

ючої функції

152