Page 37 - 4522

P. 37

m 1

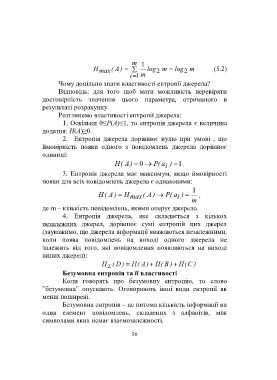

H max ( A ) log 2 m log 2 m (5.2)

i 1 m

Чому доцільно знати властивості ентропії джерела?

Відповідь: для того щоб мати можливість перевіряти

достовірність значення цього параметра, отриманого в

результаті розрахунку.

Розглянемо властивості ентропії джерела:

1. Оскільки 0≤P(A)≤1, то ентропія джерела є величина

додатня: H(A)≥0.

2. Ентропія джерела дорівнює нулю при умові , що

ймовірність появи одного з повідомлень джерела дорівнює

одиниці:

H ( A ) 0 (P a i ) 1.

3. Ентропія джерела має максимум, якщо ймовірності

появи для всіх повідомлень джерела є однаковими:

1

H ( A ) H max ( A ) ( P a i ) ,

m

де m – кількість повідомлень, якими оперує джерело.

4. Ентропія джерела, яке складається з кількох

незалежних джерел, дорівнює сумі ентропій цих джерел

(зауважимо, що джерела інформації вважаються незалежними,

коли поява повідомлень на виході одного джерела не

залежить від того, які повідомлення появляються на виході

інших джерел):

H ( D ) H ( A ) H ( B ) H ( C )

Безумовна ентропія та її властивості

Коли говорять про безумовну ентропію, то слово

”безумовна” опускають. Оговорюють інші види ентропії як

менш поширені.

Безумовна ентропія – це питома кількість інформації на

один елемент повідомлень, складених з алфавітів, між

символами яких немає взаємозалежності.

36