Page 162 - 4196

P. 162

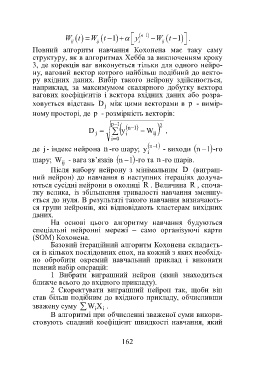

W t W t y n 1 W t 1 .

1

ij ij i ij

Повний алгоритм навчання Кохонена має таку саму

структуру, як в алгоритмах Хебба за виключенням кроку

3, де корекція ваг виконується тільки для одного нейро-

ну, ваговий вектор котрого найбільш подібний до векто-

ру вхідних даних. Вибір такого нейрону здійснюється,

наприклад, за максимумом скалярного добутку вектора

вагових коефіцієнтів і вектора вхідних даних або розра-

ховується відстань D між цими векторами в p - вимір-

j

ному просторі, де p - розмірність векторів:

p 1 2

D j y 1n W ij ,

i

i 0

n 1

1

де j- індекс нейрона n -го шару; y - виходи n -го

i

шару; W - вага зв’язків n -го та n -го шарів.

1

ij

Після вибору нейрону з мінімальним D (виграш-

ний нейрон) до навчання в наступних ітераціях долуча-

ються сусідні нейрони в околиці R . Величина R , споча-

тку велика, із збільшення тривалості навчання зменшу-

ється до нуля. В результаті такого навчання визначають-

ся групи нейронів, які відповідають кластерам вихідних

даних.

На основі цього алгоритму навчання будуються

спеціальні нейронні мережі – само організуючі карти

(SOM) Кохонена.

Базовий ітераційний алгоритм Кохонена складаєть-

ся із кількох послідовних епох, на кожній з яких необхід-

но обробити окремий навчальний приклад і виконати

певний набір операцій:

1 Вибрати виграшний нейрон (який знаходиться

ближче всього до вхідного прикладу).

2 Скоректувати виграшний нейрон так, щоби він

став більш подібним до вхідного прикладу, обчисливши

зважену суму W i X .

i

В алгоритмі при обчисленні зваженої суми викори-

стовують спадний коефіцієнт швидкості навчання, який

162