Page 34 - 4524

P. 34

похибок мережі триває до досягнення першого прошарку. Від

цього методу обчислення похибки успадкувала своє ім'я відо-

ма парадигма FeedForward BackPropagation.

При використанні правила "дельта" важливим є невпо-

рядкованість множини вхідних даних. При добре впорядкова-

ному або структурованому представленні навчальної множи-

ни результат мережі може не збігтися до бажаної точності і

мережа буде вважатись нездатною до навчання.

Правило градієнтного спуску. Це правило подібне до

правила "дельта" використанням похідної від передатної фун-

кції для змінювання похибки "дельта" перед тим, як застосу-

вати її до ваг з'єднань. До кінцевого коефіцієнта зміни, що діє

на вагу, додається пропорційна константа, яка пов'язана з оці-

нкою навчання. І хоча процес навчання збігається до точки

стабільності дуже повільно, це правило поширене і є загально

використовуване.

Доведено, що різні оцінки навчання для різних прошар-

ків мережі допомагає процесу навчання збігатись швидше.

Оцінки навчання для прошарків, близьких до виходу встанов-

люються меншими, ніж для рівнів, ближчих до входу.

Навчання методом змагання. На відміну від навчання

Хеба, у якому множина вихідних нейронів може збуджуватись

одночасно, при навчанні методом змагання вихідні нейрони

змагаються між собою за активізацію. Це явище відоме як

правило "переможець отримує все". Подібне навчання має мі-

сце в біологічних нейронних мережах. Навчання за допомо-

гою змагання дозволяє кластеризувати вхідні дані: подібні

приклади групуються мережею відповідно до кореляцій і

представляються одним елементом.

При навчанні модифікуються синаптичні ваги нейрона-

переможця. Ефект цього правила досягається за рахунок такої

зміни збереженого в мережі зразка (вектора синаптичних ваг

нейрона-переможця), при якому він стає подібним до вхідного

приклада. Нейрон з найбільшим вихідним сигналом оголошу-

ється переможцем і має можливість гальмувати своїх конку-

рентів і збуджувати сусідів. Використовується вихідний сиг-

нал нейрона-переможця і тільки йому та його сусідам дозво-

ляється коректувати свої ваги з'єднань.

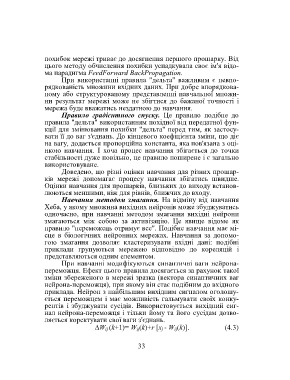

W ij (k+1)= W ij(k)+r [x j - W ij(k)]. (4.3)

33