Page 43 - 4522

P. 43

подію) умовні ентропії рівні нулю, тому

H ( B , A ) H ( A ) H ( B ).

Надлишковість джерела інформації

Звернемо увагу на такий факт: коли інформація від

джерела інформації видається у вигляді написаного тексту і в

цьому тексті є невелика кількість помилок у вигляді

пропущених букв, то з такого тексту можна вилучити

передавану інформацію. З цього спостереження можна

зробити висновок, що джерело інформації видає суттєву

(існуючі букви) і несуттєву (пропущені букви) інформацію.

При передачі інформації у вигляді тексту несуттєва

інформація є надлишковою. Отже, ми виявили ефект

існування інформаційної надлишковості джерела.

Що буде кількісною мірою інформаційної

надлишковості джерела?

Для джерела з реальним розподілом ймовірностей появи

повідомлень маємо реальне значення ентропії джерела H(A) і

можемо визначити максимально можливе значення ентропії

джерела H max(A). А отже, можемо визначити різницю H max(A) -

H(A). Цей параметр називається надлишковістю джерела.

Але цим параметром незручно користуватися для джерел з

різною кількістю повідомлень (H max(A) для них буде різною).

Усувається ця незручність нормуванням цього показника

відносно H max(A):

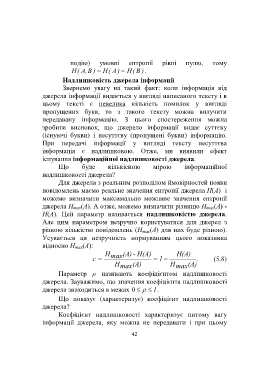

H max (A) - H(A) H(A)

с 1 . (5.8)

H max (A) H max (A)

Параметр ρ називають коефіцієнтом надлишковості

джерела. Зауважимо, що значення коефіцієнта надлишковості

джерела знаходиться в межах 0 1.

Що показує (характеризує) коефіцієнт надлишковості

джерела?

Коефіцієнт надлишковості характеризує питому вагу

інформації джерела, яку можна не передавати і при цьому

42